کلاهبرداری با هوش مصنوعی/گزارش «هممیهن» درباره یک اتفاق جـدیـد

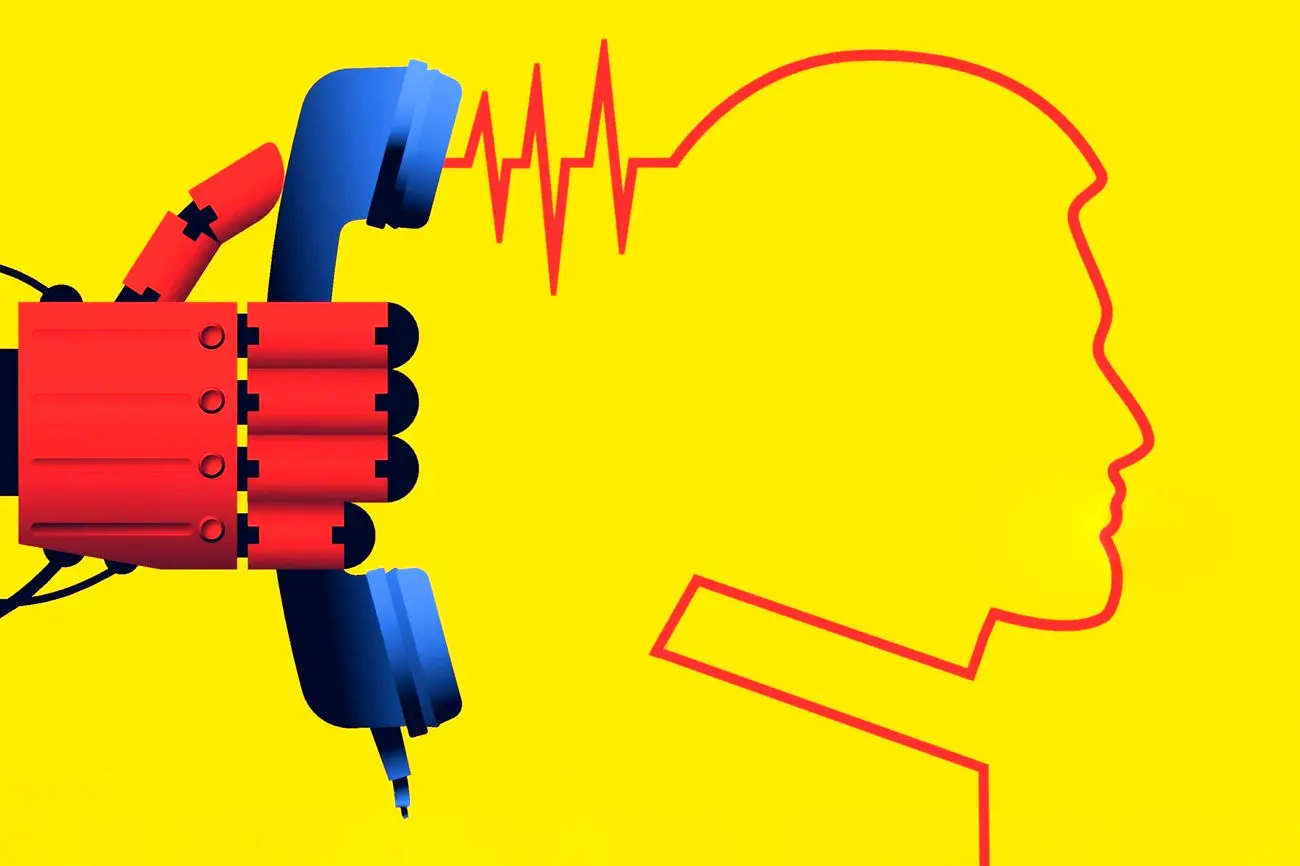

کلاهبرداران با استفاده از صدای ساختهشده با هوش مصنوعی برای گرفتن پول از خانوادهها اخاذی میکنند

«چندساعت پیش تماسی با خالهام گرفته شد و گفتند: پسر شما تصادف کرده، حالش وخیم است، او را به بیمارستان امام حسین بردیم و باید سریع پول واریز کنید تا عملاش کنیم. بعد گوشی را دادند به پسرش، صدایی دقیقاً مثل خودش! همون لحن، همون تکیهکلامها.»؛ این جملات بخشی از روایتی است که کاربری ایرانی بهتازگی در شبکه اجتماعی ایکس آن را منتشر کرده و از تجربه برخورد با کلاهبرداری با هوش مصنوعی و درخواست واریز وجه بهنام یکی از افراد آشنا نوشته است؛ اتفاقیکه در ماههای اخیر موارد متعددی از آن توسط شهروندان ایرانی گزارش شده و طبق آمارهای بینالمللی بهسرعت در جهان در حال گسترش است.

این نوع از کلاهبرداری بهکمک «دیپ فیک» انجام میشود؛ نوعی رسانه مصنوعی شامل تصویر، ویدئو یا فایل صوتی که در آن چهره یا صدای فردی با استفاده از هوش مصنوعی تغییر داده یا جایگزین میشود. این کلاهبرداری، یکی از میلیونها مورد کلاهبرداری با هوش مصنوعی در سال 2025 است. با وجود اینکه هنوز آمار رسمیای از میزان کلاهبرداری با هوش مصنوعی در ایران منتشر نشده، اما وکلای دادگستری، پلیس فتا و فعالان این حوزه درباره افزایش این نوع کلاهبرداریها در ایران هشدار میدهند.

در سال 2025، بیش از ۵۰ درصد از تقلبهای شناساییشده در پرداختها با نوعی از هوش مصنوعی یا دیپ فیک انجام شدهاند و حجم بازار جهانی فناوری ضدفریب از حدود ۱۳ میلیارد دلار در ۲۰۲۴ به 5/15 میلیارد دلار رسیده است.

در ادامه روایت کاربری که اخیراً دراینباره در شبکه ایکس نوشته، آمده است: «خاله و شوهرخالهام در شوک بودند، اصلاً شک نکردند و چندینبار پول واریز کردند. تماسگیرندهها هم مدام زنگ میزدند و میگفتند: پول کم آمده، زودتر بریزید، وقت نداریم، حالش در حال بدترشدن است. وقتی سقف کارتها پر شد، برادرم هم برای کمک وارد ماجرا شد و چندینبار پول واریز کرد.

او با موتور بهسمت بیمارستان امام حسین تهران رفت، چون فکر میکرد به آنجا منتقل شده. تا اینجا چندیننفر برای کمک وارد ماجرا شدند اما تماسگیرندهها بعد از فهمیدن موضوع عنوان کردند بیمارستان امام حسین کرج هستند. شما در نظر بگیرید تمام آن باگها و راهحلهایی که با خواندن این متن به ذهن شما میآید، ممکن است به ذهن خانوادهای که شوکهشده و مغزش کار نمیکند، نرسد. همانموقع برادرم شک کرد و تصمیم گرفت با خودِ پسر خاله تماس بگیرد.

تماس تصویری گرفت و دید کاملاً سالم است، جای دیگری است و از هیچچیز خبر ندارد. آنجا تازه فهمیدیم همهچیز یک کلاهبرداری حرفهای بوده با صدای تقلیدی ساختهشده توسط هوش مصنوعی. وقتی موضوع را به یکی از آشناها گفتیم با شنیدن اول داستان عنوان کرد کلاهبرداریه، هفتهپیش برای آشنای او هم این اتفاق افتاده؛ سناریویی مشابه با صدای دخترشان که وقتی امکان واریز پول نبوده، طلا و دلار گرفتند.»

احسان گلمحمدی، روزنامهنگار ایرانی هم تجربه مشابهی از کلاهبرداری با صدای شبیهسازیشده به کمک هوش مصنوعی دارد. او مدتی پیش نوشته بود که کلاهبرداران با استفاده از هوش مصنوعی، درخواست واریز فوری پول را مطرح کرده بودند. گلمحمدی حالا به «هممیهن» میگوید، تنها مسیر پیگیری این کلاهبرداری مراجعه حضوری به پلیس فتاست.

او میگوید: «یکی از روشهای تازه کلاهبرداری که برای چند نفر از نزدیکان رخ داده، از این قرار است که فردی با آنها تماس گرفته و با صدایی بسیار شبیه یکی از دوستان و بستگانشان از آنها تقاضای واریز فوری پول کرده است، اما وقتی آنها پول را واریز کردهاند و برای تأیید واریز پول با آن دوست یا فامیل خود تماس گرفتهاند، متوجه شدهاند که اصلاً او چنین تماسی با آنها نگرفته و از آنها کلاهبرداری شده است.

این تماسها با افراد ادامه داشت تااینکه دست بر قضا در یکی از این تماسها، فردی که با صدای شبیهسازیشده آن فرد با دوستاش تماس گرفته بودند، در کافهای کنار همان دوستاش حضور داشت و بدینترتیب ماجرای کلاهبرداری لو رفت و مشخص شد، افراد کلاهبردار وقتی گوشی تلفن فردی را هک و به دفترچه تلفن او دسترسی پیدا کردهاند با استفاده از هوش مصنوعی یا دستگاه تغییر صدا، از سیمکارتی که ناشناس بوده با افراد تماس تلفنی گرفتهاند تا بیشتر اعتماد فرد را جلب و درخواست پول کنند.

اما اینکه چگونه میتوان در مقابل این تکنولوژی، از جامعه در مقابل تبهکاران حفاظت کرد، نیازمند آموزش و اطلاعرسانی دستگاههای ذیربط است. با یکی از مقامات پلیس فتا که این موضوع را در میان گذاشتیم، او تاکید کرد تنها راه این است که تلفن را قطع کنید و خودتان با آن فرد تماس بگیرید.»

نمونه پروندههای کلاهبرداری با هوش مصنوعی در ایران کمکم در میان خبرها دیده میشود و نمونه آن پروندهای مربوط به جعل نسخههای پزشکی با استفاده از هوش مصنوعی است؛ روز یکشنبه همین هفته، معاون مبارزه با جعل و کلاهبرداری پلیس آگاهی پایتخت اعلام کرد که ۲۶ شهریورماه امسال پروندهای با موضوع جعل نسخه پزشکی با دو متهم و تعدادی نسخه پزشکی مورد پیگیری قرار گرفت.

در یکسال گذشته روایتهای دیگری از این نوع کلاهبرداری در ایران منتشر شده است؛ سال گذشته یکی از کاربران شبکه ایکس نوشت: «ماه قبل پسرعمهام به عموم زنگ میزنه که براش مشکلی پیش اومده و ۱۰میلیون به حسابش بریزه و تا شب برمیگردونه. عموم هم پول رو میریزه. دو هفته میگذره ولی خبری از پسرعمهام نمیشه. عموم زنگ میزنه بهش که چی شد مشکلت حل شد؟ پسرعمهام بیخبر میگه چه مشکلی؟ اینجا تاره میفهمن کلاهبرداری بوده و شکایت میکنن. بعداً از طریق پلیس فتا متوجه میشن طرف با استفاده از هوش مصنوعی، صدای پسرعمهام رو تقلید کرده و افراد زیادی بههمینشکل به مشکل خوردن.»

مدتی پیش پلیس فتا در هشداری رسمی به مردم اعلام کرد: «هموطن عزیز، در صورت دریافت پیام درخواست وجه از مخاطبین خود، حتماً قبل از واریز، با تماس تلفنی از صحت آن مطمئن شوید. هک گوشی و درخواست پول از مخاطبین، یکی از ترفندهای مهم مجرمان سایبری است. لطفاً هوشیار باشید.»

این هشدار پلیس فتا در ادامه موج رو به افزایش پروندههای کلاهبرداری اینترنتی از طریق نفوذ به تلفنهمراه یا حسابهای شخصی کاربران، صادر شده است. بررسیهای کارشناسان امنیت سایبری نشان میدهد که در ماههای اخیر، مجرمان با دسترسی به اطلاعات مخاطبان کاربران، اقدام به ارسال پیامهایی با لحن اضطراری و دوستانه کرده و قربانی را به انتقال فوری وجه ترغیب میکنند.

براساس دادههای پلیس فتا، شیوه جدید مجرمان، آمیزهای از مهندسی اجتماعی و نفوذ فنی است؛ آنان ابتدا با نصب بدافزار یا لینک جعلی، کنترل بخشی از دادههای تلفن قربانی را در دست گرفته، سپس از اعتماد متقابل میان افراد سوءاستفاده میکنند. دراینمیان، کاربران اغلب بهدلیل «حجم اعتماد دیجیتالی بالا در بین دوستان»، بدون تماس تلفنی یا راستیآزمایی، اقدام به واریز وجه میکنند و متوجه موضوع پس از انجام تراکنش میشوند.»

هشدار درباره افزایش کلاهبرداری با هوش مصنوعی در ایران

بزرگترین جهش تهدید طی دو سال اخیر، کلاهبرداری مبتنی بر هوش مصنوعی مولد است؛ یعنی استفاده از مدلهای تولید تصویر، ویدئو و صدا برای جعل هویت. نشریه راهپرداخت مدتی پیش نوشت که گزارشهای تخصصی در سال ۲۰۲۵ میگویند که بیش از نیمی از موارد تقلب، شناساییشده در پرداخت و خدمات مالی، حالا بهنوعی شامل سوءاستفاده از هوش مصنوعی یا محتوای «دیپفِیک» بودهاند؛ این یعنی دیگر با «تصویر دزدیدهشده از کارت ملی» طرف نیستیم؛ با ویدئویی طرفیم که فرد هرگز آن را ضبط نکرده، اما لب میزند، پلک میزند و درخواست انتقال پول میدهد. کارشناسان حوزه فتا توصیه میکنند کاربران علاوه بر تماس تلفنی پیش از هرگونه انتقال وجه، از فعالسازی احراز هویت دومرحلهای در پیامرسانها و شبکههای اجتماعی غافل نشوند و از نصب برنامههای ناشناخته یا کلیک بر روی لینکهای تبلیغاتی و جایزهنما خودداری کنند.

علیرضا طباطبایی، وکیل دادگستری در حوزه جرائم سایبری است و به «هممیهن» میگوید، هنوز با پروندهای که با استفاده از هوش مصنوعی در آن کلاهبرداری رخ داده باشد، روبهرو نشده، بااینحال باتوجه به اینکه این نوع از کلاهبرداریها در جهان رخ میدهد، بهزودی شاهد تشکیل پرونده دراینباره در ایران هم خواهیم بود: «در این نوع از کلاهبرداریها از تکههایی از صدا و ویدئوهای افراد استفاده میکنند و فیلمهایی را با هوش مصنوعی میسازند و برای خانوادهها میفرستند تا آنها را به پرداخت پول ترغیب کنند. برای مثال با هوش مصنوعی صدا را تغییر میدهند و میگویند، من را گروگان گرفتهاند یا در بیمارستان هستم و در قالب یک تماس تلفنی به اشخاص نزدیک، درخواست پول میکنند.

در کشورهای دیگر این موارد بسیار اتفاق افتاده و حتی بهعنوان مدیرعامل شرکت، تماس صوتی با صدای تغییرداده شده به حسابدار شرکت گفته شده که پولی را به حسابی دیگر واریز کند. او از راههای پیشگیری از مواجهه با این کلاهبرداریها گفت و توصیه کرد که شهروندان در درجه اول بههیچعنوان به تلفنهای ناشناس پاسخ ندهند؛ چون ممکن است صدای آنها ضبط و شبیهسازی و به واسطه آن مشکلاتی ایجاد شود.

او میگوید، دومین اقدام پیشگیرانه این است که مردم فیلمی از خودشان در شبکههای اجتماعی منتشر نکنند؛ چون ممکن است برخی کلاهبرداران بهواسطه همین فیلمها و به کمک فناوری دیپ فیک از آنها کلاهبرداری کنند. از نگاه این وکیل دادگستری، سومین نکتهای که شهروندان باید دراینزمینه به یاد داشته باشند این است که اگر پیام متنی، صوتی یا ویدئویی از آشنایان خود دریافت کردند که در آن درخواست کمک مالی یا واریز پول مطرح شده بود، حتماً پیش از واریز، یکبار صحت این پیام را با خود فرد، بررسی کنند.

قانون جرائم رایانهای در سال ۱۳۸۸ برای تعیین مصادیق استفاده مجرمانه از سامانههای رایانهای و مخابراتی به تصویب مجلس شورای اسلامی رسید. انواع جرائم رایانهای به سه دستهی کلی تقسیم میشوند که شامل خرابکاری رایانهای، کلاهبرداری رایانهای و جاسوسی رایانهای هستند.

امروزه اصلیترین حوزه مربوط به جرائم رایانهای که پیگیری آن توسط وکیل جرائم سایبری انجام میشود، جرم هک و جرائم اقتصادی رایانهای است که صرفنظر از ضررها و خسارتهای اتفاقی که حاصل بیمبالاتی وارده به سامانههای رایانهای است، به هفت دسته تقسیم میشوند: دسترسی غیرمجاز به دستگاههای پردازش داده، جرائم اقتصادی سنتی به کمک پردازش دادهها (DP)، جرائم مربوط به رایانه علیه حقوق فردی، خصوصاً علیه حق حریم خصوصی شهروندان، کلاهبرداری از طریق دستکاری رایانهای سیستم پردازش داده، جاسوسی رایانهای و سرقت نرمافزار، خرابکاری رایانهای و سرقت خدمات.

طباطبایی میگوید، موارد کلاهبرداری با استفاده از هوش مصنوعی نیز با استفاده از قانون جرائم رایانه بررسی میشود: «قانون مرتبط با این جرائم بسته به نوع نتیجهای است که حاصل میشود؛ اگر نتیجه آن برداشت وجه از حساب کسی باشد، علاوه بر جعل رایانهای، قانون مربوط به کلاهبرداری رایانهای هم استفاده میشود.

اگر برداشت وجه انجام نشود و صرفاً شخص به جعل اقدام کند، این اقدام جعل رایانهای محسوب میشود. اگر فرد تصویر کسی را بهصورت تقلبی بسازد و آن را منتشر کند، علاوه بر جعل رایانهای، میتواند مشمول قانون مربوط به تصاویر مستهجن و مبتذل هم باشد. درنهایت نیازی به قانون جدیدی نیست و قانون جرائم رایانهای آن را پوشش میدهد.»

مراقب «دیپ فیک» صوتی باشید

در سالهای اخیر نمونههای متنوعی از کلاهبرداری به روش مهندسی اجتماعی وجود داشت که طبق آن، کلاهبردار حساب تلگرام یا سایر پیامرسانهای فرد قربانی را هک میکرد، سپس از طریق آن حساب، برای مخاطبان قربانی پیامی در راستای واریز وجه (مثل واریز پول بیمارستان بهدلیل گرفتار شدن در شرایطی بحرانی) یا دریافت کد ورود به یک سیستم بهبهانههای مختلف (مثل ارسال پیام برای گرفتن کد ورود دانشآموزان به یک پیامرسان از طرف حساب هکشده مدیر مدرسه بهبهانه حضور و غیاب که اخیراً بهصورت گسترده اتفاق افتاده بود) ارسال میکردند که باتوجه به ارسال پیام از طرف شخصی آشنا، اعتماد کاربر جلب میشد و روند کلاهبرداری از قربانیها ادامه پیدا میکرد.

این روشهای مهندسی اجتماعی، حالا با ظهور ابزارهای هوش مصنوعی پیشرفتهتر شدهاند و توانایی جعل صدا، تولید متنهای بسیار قابلباور و ساخت محتوای تصویری یا ویدئویی باورپذیر، سطح فریبکاری را بهطور چشمگیری افزایش داده است.

میلاد نوری، برنامهنویس است و درباره انواع کلاهبرداری با هوش مصنوعی و مواردی که در ایران رخداده به هممیهن توضیح میدهد. او میگوید، مهمترین و فریبندهترین انواع کلاهبرداری مبتنی بر هوش مصنوعی که امروز در ایران هم شاهد آن هستیم ،عبارت است از دیپفیک صوتی (Voice Deepfake) که در آن جعل صدای افراد آشنا برای جلباعتماد و درخواست انتقال وجه، نصب اپلیکیشن مخرب و بدافزار بهبهانه دریافت وام و مواردی دیگر یا گرفتن اطلاعات حساس مثل کد ورود به یک سیستم صورت میگیرد.

او از موارد متعدد کلاهبرداری با جعل صدا در ماههای اخیر خبر میدهد و میگوید: «در ایران در ماههای اخیر موارد متعددی اتفاق افتاده که با صدای جعلی یکی از دوستان و آشنایان، با فرد قربانی تماس گرفته میشود و درخواست فوری انتقال پول یا ارسال کد تأییدشده است.

در این روش، فرد تماسگیرنده خود را در موقعیتی اضطراری (مثلاً گرفتارشدن در بیمارستان بهدلیل تصادف، نیاز سریع به پول و...) نشان میدهد تا قربانی فرصت بررسی با دقت بیشتر را نداشته باشد.» نوری در پاسخ به این پرسش که آیا میتوان گفت کلاهبرداری با هوش مصنوعی در ایران رو به افزایش است؟ توضیح میدهد که ابزارهای تولید صدا، تصویر و متن بهواسطه هوش مصنوعی، اکنون بهراحتی در دسترس هستند و درمقابل، سطح آگاهی عمومی کاربران نسبت به این خطرها و تهدیدات بسیار کندتر رشد کرده است. بهویژه ترکیب این فناوریها با روشهای شناختهشده مهندسی اجتماعی، باعثشده تعداد و پیچیدگی حملات افزایش یابد.

شهروندان عادی چطور میتوانند این موارد را تشخیص دهند یا پیشگیری کنند؟ نوری توصیه میکند هر نوع دریافت پیام متنی یا صوتی، همچنین تماس صوتی که درخواست فوری پول یا دریافت کد ورود به یک سرویس یا هر اطلاعات حساس دیگری دارد، حتی اگر صدا آشنا و متعلق به اعضای خانواده و افراد بسیار نزدیک هم باشد، باید مشکوک تلقی شود و تماس باید سریعاً قطع شود و از طریق تماس مستقیم (ترجیحاً تصویری) با شماره اصلی کسی که او را میشناسیم، صحت موضوع و درخواست را بررسی کنیم.

او از برخی اقدامات پیشگیرانه و مهم میگوید که میتواند امنیت ما در مقابل حملات را یکقدم بیشتر کند: فعالسازی احراز هویت دومرحلهای در همه حسابها و پیامرسانها و آموزش گسترده بهخصوص به کودکان و افراد مسن درباره مفهوم «هویت جعلی دیجیتال» و خطر به اشتراکگذاری کدها و اطلاعات حساس: «در صورت وقوع هک یا سوءاستفاده به این روشها، پس از خارجکردن دستگاههای هکر از حساب هکشده، حتماً از طرق مختلف (از طریق پست/ استوری در شبکههای اجتماعی یا روشهای عمومی دیگر) مخاطبان را آگاه کنید. چراکه هریک از آنها از طریق نصب بدافزاری که ممکن است از طرف شما برایشان ارسال شده باشد، میتوانند حلقه بعدی این زنجیره کلاهبرداری باشند.»

رشد نگرانکننده کلاهبرداری با هوش مصنوعی در ایران

ارژنگ ملک، رئیس کارگروه ارتباط با صنعت کمیسیون هوش مصنوعی و علم داده نظام صنفی رایانهای استان تهران به «هممیهن» میگوید، کلاهبرداری با هوش مصنوعی قطعاً در کشور در حال گسترش است؛ چون در همه دنیا با سرعتی بسیار زیاد در حال رشد است و در ایران هم سرعتی نگرانکننده دارد.

علت اصلی آن هم ناآگاهی مردم از این جنس کلاهبرداریها و هوش مصنوعی است. علاوه بر این بسیاری از ابزارهایی که با کمک هوش مصنوعی کار میکند، ساده و رایگان در اختیار مردم قرار دارد؛ ابزارهایی مثل تقلید صدا تا دیپ فیکهای تصویری و مدلهای زبانی مختلف. خوراک این هوش مصنوعیها هم برای یادگیری شامل صدا، تصویر خام و اطلاعات شخصی ماست که بهصورت عمومی در بسترهای مختلف وجود دارد که کار را برای کلاهبرداران سادهتر میکند و این جنس کلاهبرداری هم روزبهروز در حال افزایش است.

ملک توضیح میدهد که هنوز آمار رسمی درباره رایجترین انواع کلاهبرداری با هوش مصنوعی در ایران منتشر نشده، اما طبق گزارشهای مردمی و پلیس، بیشترین کلاهبرداریها در ایران با استفاده از هوش مصنوعی مربوط به دیپ فیکهای صوتی است که از مردم کلاهبرداری مالی میکنند. مرحله بعد، فیشینگهای پیشرفته است.

بهواسطه ناآگاهی عمومی مردم نسبت به تکنولوژی، هنوز هم موارد زیادی از کلاهبرداری با لینکهای جعلی کلاسیک توسط مردم دیده میشود، حالا تصور کنید که هوش مصنوعی هم به این حوزه وارد شود؛ در این شرایط حتماً نرخ آن افزایش پیدا میکند. مرحله بعد هم کلاهبرداری در قالب کمپینهای مربوط به پیشبینی بازارهای مالی به کمک چتباتهاست.

رئیس کارگروه ارتباط با صنعت کمیسیون هوش مصنوعی و علم داده نظام صنفی رایانهای استان تهران میگوید: «مهمترین کلاهبرداریهایی که با هوش مصنوعی صورت میگیرد، دیپ فیک است که در بستر صوت و تصویر انجام میشود و قربانیان متعددی دارد. در ایران هم مهمترین و بزرگترین کلاهبرداریهایی که با استفاده از هوش مصنوعی انجام میشود، در حوزه دیپ فیکهای صوتی است.

به این صورت که با صدای یکی از آشنایان، با فرد تماس گرفته و در سناریویی، یک شرایط بحرانی برای قربانی ترسیم میشود و غالباً درخواست وجه مالی میشود. هر ماشین هوش مصنوعی برای تقلید صدا نیاز به تعدادی نمونه صوتی دارد که بهواسطه گسترش شبکههای اجتماعی، نمونه صدای افراد در دسترس است و بهاینترتیب برای ماشین هوش مصنوعی میسر است که صدای افراد را تقلید کند.

ازطرفدیگر، یک ماشین هوش مصنوعی دیگر که در زمینه تبدیل متن به صوت عمل میکند، وارد بازی میشود و هر متنی را که در اختیار آن قرار دهیم، با صدای تقلیدشده به قربانی کلاهبرداری ارائه میکند. این کار بهراحتی میتواند اطمینان او را جلب کند و فرد، قربانی کلاهبرداری شود.»

ملک میگوید، یکی دیگر از انواع این کلاهبرداریها، دیپ فیکهای تصویری است که مشابه همین الگوریتم است و برای یادگیری نیاز به نمونه تصویری دارد که اغلب در بستر وب موجود است. در این کلاهبرداریها یک ماشین هوش مصنوعی که حرکات صورت و تصویر را شبیهسازی و پیامی را به قربانی منتقل میکند، ایجاد میشود. میزان این کلاهبرداری کمتر از دیپ فیکهای صوتی و معمولاً در لایههای بالاتر رخ میدهد و برای اخاذیها و سوءاستفادهها انجام میشود.

به گفته او یکی دیگر از این کلاهبرداریها، فیشینگ است: «نمونه آشنای این نوع از کلاهبرداری لینکهایی است که برای افراد از طریق پیام کوتاه یا شبکههای اجتماعی ارسال میشود و با کلیک روی آن یک سوءاستفاده و کلاهبرداری مالی صورت میگیرد. در این روش هوش مصنوعی میتواند متن پیام، ایمیل یا پیام کوتاه حاوی لینک فیشینگ را شخصیسازی کند و درنهایت قربانی با یک پیام از یک فرد آشنا روبهرو میشود که همان ادبیات و کلمات آشنا را دارد و اطمینان قربانی جلب و روی لینک کلیک میکند. یادگیری هوش مصنوعی هم بهواسطه پیامهای ما در شبکههای اجتماعی در بسترهای مختلف است و با لحن و ادبیات کلمات ما آشنا میشود و میتواند پیامهای ما را شبیهسازی کند.»

رئیس کارگروه ارتباط با صنعت کمیسیون هوش مصنوعی و علم داده نظام صنفی رایانهای استان تهران تاکید میکند که در بسیاری از موارد در لایهای دولتی و سطوح بالاتر جامعه، این فیشینگها برای سوءاستفاده اطلاعاتی صورت میگیرد و هکرها برای جلب اطمینان افراد، یک ایمیل شخصیسازیشده برای افراد ارسال و او را وادار به کلیک روی یک لینک میکنند و درنهایت کلاهبرداری صورت میگیرد: «یکی دیگر از انواع کلاهبرداری با هوش مصنوعی مربوط به چتباتها و رباتهای پیشبینیکننده در بازارهای مالی است.

هوش مصنوعی توان پیشبینی مدلهای تکرارشونده و متغیرهایی که در بازار اثرگذارند را دارد، اما اغلب آنهایی که درحالحاضر در اختیار مردم است و روی آن تبلیغات انجام میشود، با هدف جمعآوری اطلاعات از کاربران و سوءاستفادههای مالی است و درعمل پیشبینی اتفاق نمیافتد؛ چون کاربر را درگیر روندی میکند که اطلاعات شخصی را در اختیار ربات قرار دهد و در قبال آن، اطلاعاتی از وضعیت بازار دریافت کند، اما درعمل از اطلاعات مالی و شخصی افراد سوءاستفاده میشود.

یکی دیگر از انواع این کلاهبرداریها در شبکههای اجتماعی انجام میشود که طبق آن حسابهای کاربری ساخته میشود که یک هوش مصنوعی آن اکانت را مدیریت میکند و طبق هدفی که برای آن ترسیم شده، میتواند جریانسازی، سوءاستفاده فکری، دریافت اطلاعات و انواع کلاهبرداری را انجام دهد. این حسابهای کاربری غیرواقعی در دنیا و ایران درحال رشد است و نوعی دیگر از کلاهبرداری به کمک هوش مصنوعی است.»

ملک اضافه میکند که نوعی دیگر از این کلاهبرداریها استفاده از ناآگاهی مردم درقبال استفاده از هوش مصنوعی است: «وقتی پدیده نوظهوری در جامعه رخ میدهد، افرادی به وجود میآیند که میخواهند از ناآگاهی مردم سوءاستفاده کنند؛ مثل دورههای هوش مصنوعی، آموزش هوش مصنوعی، پولدارشدن با هوش مصنوعی، پکیج هوش مصنوعی و موارد مشابه. یعنی هوش مصنوعی را به یک راهگشا که صرفاً با پرداخت پول و دریافت یک محتوا یا نرمافزار، اغلب مشکلات برطرف میشوند، تبدیل میکند اما بیشتر آنها سوءاستفاده و کلاهبرداری از قربانیان است.»

او به مردم توصیه میکند که چند نکته کلیدی را برای جلوگیری از قربانیشدن توسط هوش مصنوعی در نظر داشته باشند، بهخصوص وقتی با کلاهبرداری با استفاده از دیپف یک و تماس صوتی نامعتبر روبهرو میشوند: «اگر با تماسهای مربوط به درخواست کمک مالی از سوی افراد آشنا روبهرو شدید، صرفاً به یک صدا بسنده نکنید و اگر ممکن است تماس تصویری برقرار کنید یا آن تماس را قطع کنید و خودتان مستقیم با فردی که تماس گرفته، تماس برقرار کنیم تا بتوانیم تایید چندمرحلهای انجام دهیم. نکته دوم این است که اساساً کلاهبرداران از ترس و عجله قربانیان سوءاستفاده میکنند و آنها را در معرض تصمیم عجولانه قرار میدهند.

در این شرایط باید خونسردی خود را حفظ کنیم تا تصمیمی عاقلانه بگیریم و درگیر هیجان و فشار آن تماس صوتی نشویم. تا جایی که ممکن است در یک بستر ناشناس، اطلاعات عمومی؛ از نشانی تا اطلاعات حساب بانکی خود را منتشر نکنیم. چون کلاهبرداران با در اختیار داشتن این اطلاعات، اعتماد قربانیان را جلب میکنند و میتواند حتی بدون اطلاع ما، کلاهبرداری کنند. حتی صدای خام ما میتواند یک خوراک برای یک ماشین هوش مصنوعی باشد که صدای ما را تقلید کند.» او تاکید میکند تا جای ممکن باید بدانیم در کدام لینک در حال پرداخت پول یا وارد کردن اطلاعات هستیم.

هرزمان دچار این کلاهبرداریها شدیم بلافاصله به پلیس اطلاع دهیم و این تجربه را به اطرافیان انتقال دهیم: «بهواسطه فیلترینگ گسترده در ایران، مردم مجبور به استفاده از فیلترشکنهای مختلفیاند که همین ضریب امنیت را کاهش میدهد. وقتی آیپی ما، پایدار و مطمئن نیست و دائم در حال تغییر نباشد، راحتتر مورد سوءاستفاده قرار میگیریم.»